可處理數百萬字資料量的AI模型: Ring Attention

在人工智能(AI)的世界裡,數據是一切的基礎。不過,當我們談到數據規模,傳統的AI模型往往會遇到瓶頸。想像一下,如果你有一本包含數百萬字的書,而你的AI模型只能讀幾千字,那會是多麼的局限!但現在,有了一種名為「Ring Attention」的新技術,這一切都有了翻天覆地的變化。這項由UC Berkeley和Google DeepMind的研究人員開發的技術,不僅解決了記憶體限制的問題,還大大提高了AI模型在處理大規模數據方面的能力。

傳統轉換器(Transformers)的記憶體限制

轉換器(Transformers)自從出現以來,就在自然語言處理(NLP)和機器學習(ML)領域中發揮了巨大的作用。然而,這種架構有一個明顯的缺點:它們在處理長序列數據時會遇到記憶體限制。這主要是因為轉換器使用了一種名為「自我注意力」(self-attention)的機制,這是一個非常記憶體密集型的過程。傳統上,這一限制使得轉換器難以擴展其上下文長度,從而限制了它們在處理大規模數據集方面的能力。

Ring Attention:一個突破性的解決方案

為了解決這個問題,UC Berkeley的研究人員開發了一種名為「Ring Attention」的新方法。這種方法的核心思想是將計算過程在多個設備之間以塊(block)的形式分佈。這樣,每個設備只需要處理一小部分的數據,從而大大減少了記憶體的需求。

更具體地說,Ring Attention採用了一種環狀(ring-like)的結構,將鍵值(key-value)塊從一個設備傳送到另一個設備。這種塊式的注意力(blockwise attention)和前向運算(feedforward operations)允許每個輸入塊具有特定的操作,從而實現了高效的計算。

實際應用和未來展望

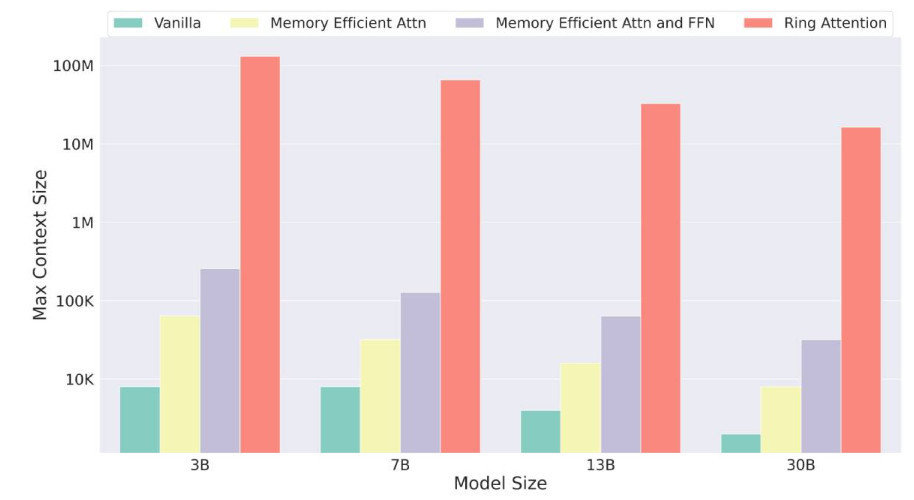

這種新方法不僅克服了記憶體限制,還使得AI模型能夠處理比以前長得多的序列。根據研究報告,Ring Attention能夠處理的序列長度比先前的記憶體高效模型長達500倍。這意味著,現在的AI模型可以輕鬆處理數百萬字的數據量,這對於大規模的視頻、語音和語言模型來說是一個巨大的突破。

這項技術的潛在應用範圍非常廣泛,從大規模的視頻語言模型到科學數據,如基因序列等。此外,這項研究還為未來探索最大序列長度和最大計算性能提供了新的可能性。

如何實現Ring Attention的技術

實現Ring Attention的關鍵在於如何有效地將計算過程分佈到多個設備上。這裡有幾個實用的步驟:

塊劃分(Block Partitioning):首先,將整個數據集分成多個小塊。

環狀結構設計(Ring Structure Design):確保所有設備都按照一個環狀結構來排列。

鍵值塊傳輸(Key-Value Block Transfer):在進行計算的同時,將鍵值塊從一個設備傳送到另一個設備。

塊式注意力和前向運算(Blockwise Attention and Feedforward Operations):每個設備對其負責的數據塊進行注意力和前向運算。

這樣,每個設備只需要負責一部分的計算,從而大大減少了整體的記憶體需求。

結論:打破記憶體限制,開啟無窮可能

Ring Attention的出現無疑是AI領域的一個重大突破。它不僅解決了長期困擾研究人員的記憶體問題,還為AI模型處理大數據提供了全新的可能。從現在起,數百萬字的數據量不再是問題,AI的應用範圍也將因此而大大擴展。

對於想要更深入了解如何加速AI模型訓練的讀者,或著如果你對AI在日常生活中的應用有興趣,可以參考InfinitesSoft的部落格。無論是在商業應用還是科學研究中,Ring Attention都將成為一個不可或缺的工具。它的出現讓我們看到了AI未來無窮的可能性,讓人充滿期待。